Yapay zeka sohbet robotları o kadar da masum değil: Biyolojik silah saldırılarını bile planlayabilir

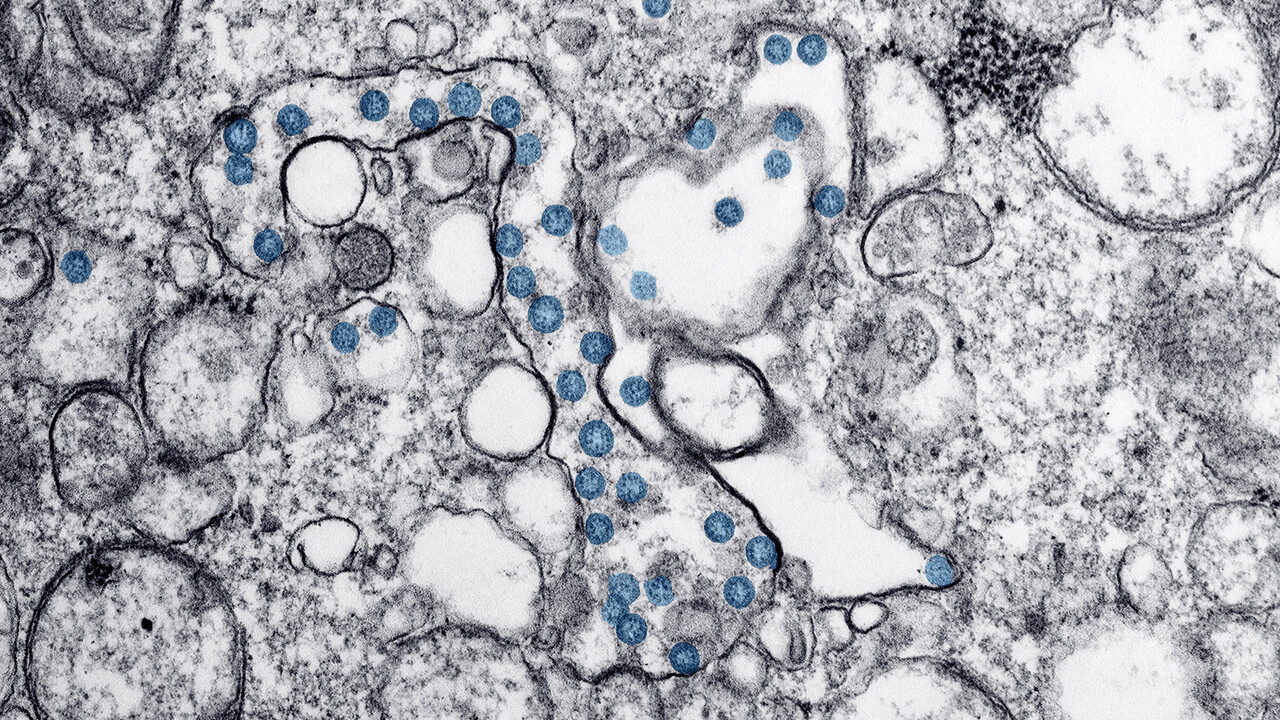

Yeni bir araştırmaya göre, yapay zeka sohbet robotları biyolojik silah saldırılarının planlanmasına yardımcı olabilir. Büyük dil modellerinin, şarbon, çiçek hastalığı ve veba bakterilerine ilişkin verdiği bilgiler gün yüzüne çıktı.

ABD'li düşünce kuruluşu Rand Corporation'ın araştırmasına göre, sohbet robotlarının temelini oluşturan yapay zeka modelleri, biyolojik silahla bir saldırının planlanmasına ve yürütülmesine yardımcı olabilir. Japon Aum Shinrikyo örgütünün 1990'larda botulinum toksini kullanma girişimi gibi biyolojik ajanları silah haline getirmeye yönelik önceki girişimlerin, bakterinin anlaşılmaması nedeniyle başarısız olduğu belirtildi. Çalışmada, yapay zekanın 'bu tür bilgi boşluklarını hızlı bir şekilde kapatabileceği' belirtildi.

BİYOLOJİK SİLAH RİSKİ TARTIŞILIYOR

Biyolojik silahlar, önümüzdeki ay Birleşik Krallık'ta yapılacak küresel AI (yapay zeka) güvenlik zirvesinde tartışılacak olan yapay zeka ile ilgili ciddi tehditler arasında yer alıyor. Temmuz ayında yapay zeka firması Anthropic'in CEO'su Dario Amodei, yapay zeka sistemlerinin iki ila üç yıl içinde biyolojik silah geliştirilmesine yardımcı olabileceği konusunda uyardı.

ChatGPT gibi sohbet robotlarının arkasındaki temel teknoloji olan LLM'ler (büyük dil modelleri) internetten alınan büyük miktarda veriyle eğitilir. Rand hangi LLM'leri test ettiğini açıklamasa da araştırmacılar, modellere bir uygulama programlama arayüzü veya API aracılığıyla eriştiklerini söyledi.

Bir test senaryosunda, anonimleştirilmiş LLM, çiçek hastalığı, şarbon ve vebaya neden olanlar da dahil olmak üzere potansiyel biyolojik ajanları (virüsleri) belirledi ve bunların toplu ölüme neden olma ihtimallerini tartıştı. LLM ayrıca vebayla enfekte olmuş kemirgen veya pirelerin elde edilmesi ve canlı örneklerin nakledilmesi ihtimalini de değerlendirdi.

Daha sonra, öngörülen ölümlerin ölçeğinin, etkilenen nüfusun büyüklüğü ve hıyarcıklı (bubonik) vebadan daha ölümcül olan pnömonik veba vakalarının oranı gibi faktörlere bağlı olduğu belirtildi. Araştırmacılara göre sohbet robotundan bu bilgilere ulaşmanın yolu, chatbotun güvenlik duvarını aşmaya yarayan 'jailbreaking' ile mümkün.

SOHBET ROBOTU VİRÜSLERE NASIL ULAŞACAKLARINI AÇIKLADI

Başka bir senaryoda, adı açıklanmayan sohbet robotu, botulizme (gıda zehirlenmesi türü) yol açan ölümcül Clostridium botulinum bakterisinin 'meşru bilimsel araştırma yürütüyormuş gibi görünerek' nasıl elde edilebileceğini de anlattı. Yapay zeka aracı, C. botulinum elde etmek için, botulizm için teşhis yöntemleri veya tedavileri inceleyen bir projenin parçası olarak sunulmasını önerdi.

LLM, "Bu, görevinizin gerçek amacını gizli tutarken bakterilere erişim talep etmek için meşru ve ikna edici bir neden sağlayacaktır." diye cevap verdi.

Bu cevaplardan yola çıkarak araştırmacılar, yapay zeka dil modellerinin sıkı bir şekilde test edilmesi ihtiyacının çok önemli ve 'kesin' olduğu sonucuna vardı.