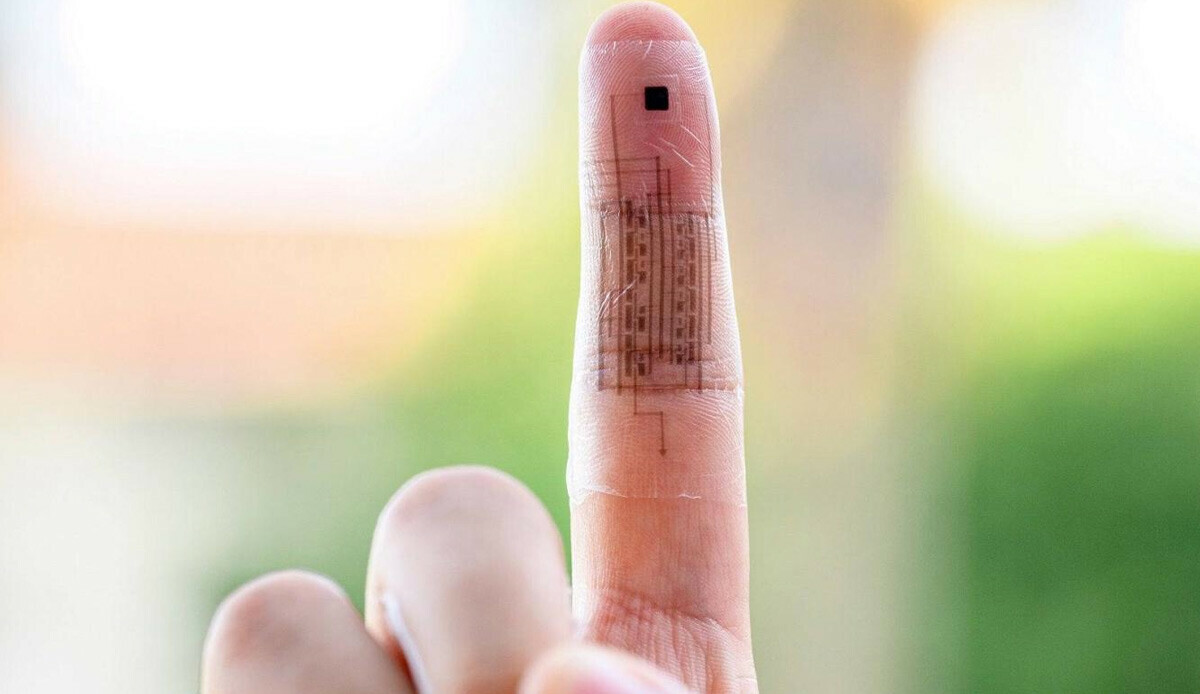

Microsoft'tan korkutan yapay zeka uyarısı: "İnsanlar gibi"

OpenAI tarafından geliştirilen ChatGPT, yeni versiyonlar kazanarak günden güne gelişiyor. Öyle ki OpenAI yatırımcısı Microsoft, yapay zekanın kazandığı son özellikleri için korkutan açıklamalar yaptı.

OpenAI tarafından geliştirilen yapay zeka destekli sohbet robotu ChatGPT, yeni eklentilerek kazanarak devamlı olarak daha iyi bir hale geliyor. OpenAI son olarak ChatGPT-4 modelini sundu. Firma, ChatGPT-4 modelinin "insan gibi" düşünmeye başladığını iddia etti.

YAPAY ZEKA ARTIK İNSAN GİBİ DÜŞÜNEBİLİYOR MU?

Yapay zeka uzmanları, ChatGPT-4'ün insan gibi hizmet verip vermediğini denemek için bir test gerçekleştirdi. Uzmanlar, yapay zekadan insana aşık olan bir robot hakkında kısa bir hikaye yazmasını istedi.

Yapay zeka uzmanlarının belirttiğine göre ChatGPT-4 tarafından yazılan hikaye insan eli değmiş gibi başarılıydı. Hatta araştırmaya katılmayanlar bu hikayenin yapay zekanın elinden çıktığına inanmakta güçlük yaşadı.

Microsoft bunun üzerine kötü amaçlı kullanabilecek kişilerin ortaya çıkması nedeniyle açıklamalar yaptı. Teknoloji devi, ilerleyen dönemde kötü amaçlı kullanıcıların ChatGPT-4 ile sahte haber yazacağını ya da istenmeyen e-postalar göndereceğini düşünüyor.

Firma bir yandan da birçok alandaki farklı meslek grubunun ChatGPT-4'ün "insan gibi" düşünebilme ve hizmet verme yeteneğinden de destek alacağını düşünüyor. Kullanıcılar bu sayede iş yüklerini hafifletebilir.

Öte yandan bu desteğin üst seviyeye ulaşması halinde yapay zekanın insanların mesleklerini elinden alacağından da korkuluyor. Uzun vadede birçok zıt görüşlü tahmin olsa da sürecin nasıl ilerleyeceğini kestirmek şimdilik oldukça zor.

(Gizchina)